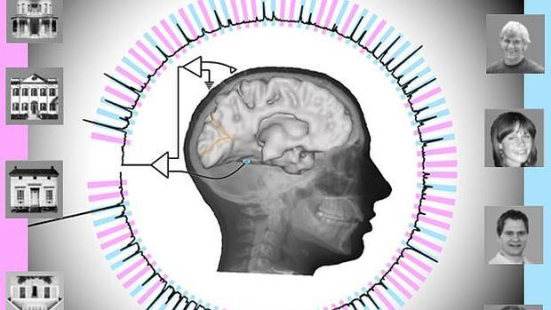

Averiguan en tiempo real lo que una persona está viendo por la actividad de sus neuronas. Es un primer paso hacia un sistema de comunicación para pacientes que no pueden hablar.

¿Se puede utilizar un ordenador para saber lo que alguien está viendo en tiempo real? La respuesta es sí. Nuestro cerebro está cada vez más “amenazado” por investigaciones que intentan averiguar lo que pasa en nuestra “caja negra” sin necesidad de palabras. Y ahora un equipo de investigadores de la Universidad de Whasington, dirigido por Rajesh Rao, un neurocientífico computacional, ha logrado predecir con un un 95 por ciento de precisión si los participantes en el estudio estaban viendo una casa, un rostro o una pantalla gris. Y lo han hecho interpretando la actividad neuronal prácticamente mientras se producía, con una demora de 20 milisegundos.

¿Se puede utilizar un ordenador para saber lo que alguien está viendo en tiempo real? La respuesta es sí. Nuestro cerebro está cada vez más “amenazado” por investigaciones que intentan averiguar lo que pasa en nuestra “caja negra” sin necesidad de palabras. Y ahora un equipo de investigadores de la Universidad de Whasington, dirigido por Rajesh Rao, un neurocientífico computacional, ha logrado predecir con un un 95 por ciento de precisión si los participantes en el estudio estaban viendo una casa, un rostro o una pantalla gris. Y lo han hecho interpretando la actividad neuronal prácticamente mientras se producía, con una demora de 20 milisegundos.

«Estábamos tratando de entender cómo se podría utilizar un ordenador para extraer y predecir lo que alguien está viendo en tiempo real», explicado Rao, experto en informática e ingeniería, y director de la National Science Foundation, de Washington.

Lo que hemos conseguido es «una prueba de concepto hacia la construcción de un mecanismo de comunicación para los pacientes que están paralizados o han tenido un derrame cerebral y están completamente bloqueadas», explica. Una prueba de concepto es una prueba de que una idea puede ser explotada de forma útil.

De cererebro a cerebro

Para Rao, las palabras pueden ser meramente una complicación. Por eso en investigaciones anteriores ha logrado establecer conexión directa entre los cerebros de dos personas sin que mediara una sola palabra. En un estudio llevado a cabo en noviembre de 2014, que involucró a seis personas, el equipo de Rao logró transmitir las señales desde el cerebro de una persona a través de Internet para controlar los movimientos de la mano de otra persona una fracción de segundo después del envío de esa señal. Fue una validación de un estudio anterior llevado a cabo en agosto de 2013, el primero en demostrar que dos cerebros humanos se pueden comunicar sin palabras.

El estudio actual es un paso más en la comunicación sin palabras. ¿Imagina que pudiera transmitir lo que está viendo a otra persona sin necesidad de hablar o hacer gesto alguno? Pues esto que podría parecer el argumento de una película de ciencia ficción, ha dado el primer paso para convertirse en realidad.

En el estudio participaron siete pacientes con epilepsia atendidos en el Harborview Medical Center en Seattle. Estos pacientes suelen aportar muchos datos sobre el funcionamiento del cerebro. En los casos en que sus ataques epilépticos no ceden con medicamentos, pueden someterse a una cirugía que lo corrija. Pero antes se les implantan unos electrodos durante una semana en los lóbulos temporales para localizar el foco epiléptico.

Durante su estancia en el hospital algunos acceden a colaborar en estudios de este tipo. Se les encargan diversas tareas cognitivas mientras están a la espera de su intervención, sin que eso suponga el uso de ningún método invasivo adicional. Gracias a los electrodos que tienen instalados, se puede registrar la actividad de esa zona del cerebro.

Lóbulos temporales

Lóbulos temporales procesan la información sensorial y es el lugar donde tienen su origen muchas crisis epilépticas. Situados detrás de los ojos y las orejas, también están implicados en la enfermedad de Alzheimer y las demencias, y también parecen ser más vulnerables a las lesiones que otras estructuras del cerebro cuando se produce algún traumatismo.

En el experimento, los electrodos que registraban la actividad del lóbulo temporal se conectaron a un potente software computacional que extrajo dos propiedades características de la señal del cerebro: «potenciales relacionados con eventos» y «cambios espectrales de banda ancha.»

Esas dos señales proceden de «cientos de miles de neuronas que activan a la vez cuando el voluntario ve una imagen por primera vez», y «tras la ola inicial de la información, del procesamiento de esa información», explica Rao.

Se mostró a los sujetos una secuencia aleatoria de imágenes en una pantalla de ordenador, durante un breve periodo (400 milisegundos), de rostros humanos y casas, intercalados con pantallas grises en blanco. Su tarea consistía en detectar la imagen de una casa que aparecía del revés. Según la localización de los electrodos en el lóbulo temporal, se producían diferentes respuestas. Algunas zonas eran sensibles a las caras y otras a las casas.

El software computacional utilizado muestrea y digitaliza las señales del cerebro 1.000 veces por segundo para extraer sus características. También analizó los datos para determinar qué combinación entre la posición de los electrodos y el tipos de señal se correlacionaba mejor con lo que cada sujeto veía.

Matemáticas para entender el cerebro

Mediante un algoritmo así elaborado lograron predecir con un 96 por ciento de precisión si estaban viendo una casa, un rostro o una pantalla gris. Esta precisión se alcanza sólo cuando potenciales relacionados con eventos y los cambios de banda ancha se combinaban, lo que sugiere que esas dos señales llevan la información complementaria.

«Tradicionalmente los científicos han examinado las neuronas de una en una para este tipo de estudios», explica Rao. «Nuestro estudio da una visión más global, a nivel de grandes redes de neuronas, de cómo una persona que está despierta y atenta percibe un objeto visual complejo.» Y considera que su estudio es trampolín para el mapeo cerebral, ya que podría ser utilizado para identificar en tiempo real qué lugares del cerebro son sensibles a cada tipo de información.

«Las herramientas computacionales que desarrollamos se pueden aplicar a los estudios de la función motora, sobre la epilepsia o la memoria», explican. Detrás un montón de cálculos matemáticos, esenciales para adentrarse en la complejidad del cerebro. En definitiva, el análisis computacional aplicado al antiguo juego del veo, veo…