La distinción del ‘yo’ es esencial para la interacción entre los seres humanos y los androides.

“¿Qué pasaría si los humanos no tuviéramos tacto? ¿Qué significa tocar algo? ¿Qué significa que te toquen?”. El que lanza las preguntas no es un filósofo, sino el ingeniero Pablo Lanillos, nacido en Madrid en 1981. Acaba de recibir una beca de 160.000 euros de la Unión Europea para intentar que los robots aprendan a reconocer su propio cuerpo. El salto tecnológico sería brutal. En la actualidad, una máquina humanoide puede ver cómo aplasta a una persona con su brazo artificial, sin darse cuenta de lo que está ocurriendo. La distinción del yo en los robots es esencial para la futura interacción entre los seres humanos y los androides.

“¿Qué pasaría si los humanos no tuviéramos tacto? ¿Qué significa tocar algo? ¿Qué significa que te toquen?”. El que lanza las preguntas no es un filósofo, sino el ingeniero Pablo Lanillos, nacido en Madrid en 1981. Acaba de recibir una beca de 160.000 euros de la Unión Europea para intentar que los robots aprendan a reconocer su propio cuerpo. El salto tecnológico sería brutal. En la actualidad, una máquina humanoide puede ver cómo aplasta a una persona con su brazo artificial, sin darse cuenta de lo que está ocurriendo. La distinción del yo en los robots es esencial para la futura interacción entre los seres humanos y los androides.

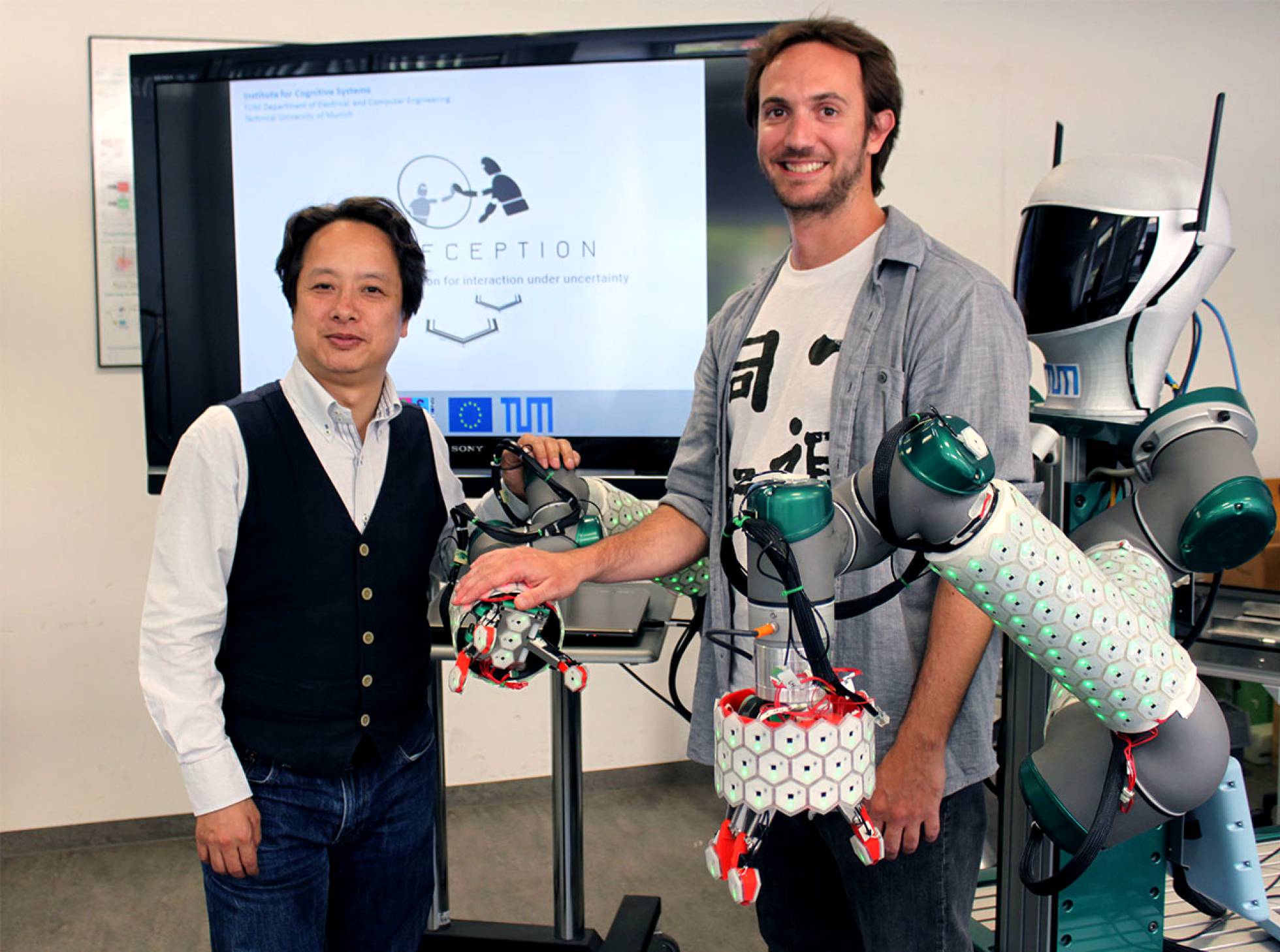

“Vamos a cubrir un robot humanoide con piel artificial”, resume Lanillos, investigador de la Universidad Tecnológica de Múnich, en Alemania. La piel, desarrollada en su laboratorio, posee múltiples sensores para medir la presión, la temperatura e incluso la proximidad de un objeto, como haría una auténtica piel humana. En la actualidad, los robots no tienen tacto. La adquisición de ese nuevo sentido permitiría a los humanoides crear “un mapa sensorial”, en palabras de Lanillos. “Quiero que los robots entiendan la relación entre las acciones que realizan y las sensaciones que reciben, para saber dónde está su cuerpo en cada momento”, explica el ingeniero, armado con algoritmos de aprendizaje.

Uno de los libros favoritos de Lanillos es El error de Descartes, de Antonio Damasio. En la obra, el neurocientífico de origen portugués derrumba el famoso “Pienso, luego existo” del filósofo francés, que sostenía que la mente existe de forma independiente al cuerpo. “No todo es corteza prefrontal”, sentencia el ingeniero madrileño, en referencia a la región del cerebro involucrada en los pensamientos complejos.

“Un ordenador te puede ganar al ajedrez, pero nunca va a coger la ficha del tablero. ¿Por qué no intentamos que un ordenador aprenda a escribir con Cuadernos Rubio todo el verano? Es mucho más complicado, pero queremos hacer robots que realmente aprendan”, señala. En su opinión, que una máquina se reconozca a sí misma es una condición necesaria para actuar de manera voluntaria e «incluso para tener pensamientos abstractos».

Los fabricantes de robots anunciaban en 2010 la inminente multiplicación de las ventas de robots asistenciales, capaces de interactuar con personas para ayudarlas o hacerles compañía. No ocurrió. La Federación Internacional de Robótica calcula ahora que entre 2016 y 2019 se venderán 8.100 robots humanoides asistenciales y otros ocho millones de robots de juguete en todo el mundo.

El ingeniero español cree que la progresión es imparable. A su juicio, “estamos más cerca de robots que puedan caminar por una casa, ayudarnos y hacernos compañía, interactuando y mirándonos a los ojos”. Hoy todavía parece ciencia ficción, pero hace 20 años casi nadie tenía ni teléfono móvil ni dirección de correo electrónico.

“La visión de la robótica en Japón es considerar a los robots como iguales, como entes con los que te puedes relacionar. En Europa, en cambio, vemos a los robots como esclavos”, reflexiona Lanillos. Su trabajo está coordinado por Gordon Cheng, director del Instituto de Sistemas Cognitivos de la universidad alemana y curtido en la escuela japonesa. “No hay que tener ningún miedo. Cuanto más conocimiento tengan los robots de su cuerpo, más seguros estaremos. Un robot que entienda que ha tocado a un ser humano puede aprender para no hacerle daño”, señala Lanillos.

“Este proyecto es de primer orden”, opina Selmer Bringsjord, director del Laboratorio de Inteligencia Artificial y Razonamiento del Instituto Politécnico Rensselaer, en EE UU. En 2015, Bringsjord anunció que sus máquinas habían solucionado un clásico problema de lógica. El investigador comunicó a tres de sus robots humanoides que dos de ellos habían recibido una píldora que les impedía hablar. La misión de los tres era adivinar cuál de ellos todavía podía emitir sonidos. Al cabo de un rato, uno de los robots dijo: “No lo sé”. Al escucharse, proclamó: “Perdón, ahora sí lo sé”. Para el investigador, se puede afirmar que la máquina es consciente de sí misma.

Bringsjord recuerda también el trabajo pionero del científico Brian Scassellati, de la Universidad de Yale (EE UU). En la última década, uno de sus robots, bautizado Nico, ha aprendido a diferenciar su propio brazo entre otros objetos en movimiento. Además, Nico reconoce su imagen en un espejo, según los resultados publicados por Scassellati. En opinión de Lanillos, estos experimentos eran “muy simplificados, con pocas variables”, no como los que preparan ahora en la Universidad Tecnológica de Múnich.

El ingeniero español cree que los robots son, además, una plataforma muy interesante para estudiar cómo funcionan los animales y los humanos. En las máquinas, los psicólogos cognitivos pueden probar sus hipótesis sobre el aprendizaje. “Si un robot mueve el brazo delante de un espejo muchas veces, y ve que su reflejo siempre se mueve, no hace falta hacer una grandísima reflexión sobre el yo. Así ocurre en muchos animales”, opina Lanillos. “Hay primatólogos que dicen que los roboticistas estamos muy lejos de entender qué significa reconocerse a sí mismo. Pero a lo mejor los humanos somos más robots de lo que creemos y no al revés”.

«SOY UN CEREBRO FUGADO»

Pablo Lanillos se doctoró en inteligencia artificial en la Facultad de Informática de la Universidad Complutense de Madrid. En la última década, ha realizado estancias largas en centros como el Instituto Tecnológico de Massachusetts (EE UU), la Escuela Politécnica de Lausana (Suiza) y el Centro de Robótica de la Universidad de Sídney (Australia). «Soy un cerebro fugado», reconoce. «Me fui porque el modelo de investigación de España no me permitía crecer como científico. No salían plazas, había reducciones de presupuestos… Múnich es una de las ciudades más ricas de Alemania y le dedica mucho dinero a ciencia, porque saben que repercute en el PIB a largo plazo», reflexiona.